Erilaiset organisaatiot miettivät omaa suhtautumistaan tekoälyyn ja miten sitä otetaan käyttöön. Pääasiassa käsittelen opetuksen ja koulutuksen alaa. Asian käsittelyssä on ainakin syytä huomioida ja tiedostaa seuraavia seikkoja.

Tekoälyn määrittely ja eri teknologiat

Usein puhutaan tekoälystä ja tarkoitetaan esimerkiksi suuria kielimalleja ja niiden pohjalle tuotettuja palveluita. Tekoäly on ns. yläkäsite ja se jakautuu moneksi erilaiseksi teknologiaksi, tunnetuimpia ovat:

- Koneoppiminen

- Neuroverkot

- Luonnollisen kielen prosessointi (NLP)

- (Laajat) kielimallit (L)LM

Kielimallit ovat kehittyneet viimeisten vuosien aikana ja ovat useimmille tuttuja. Tunnettuja kielimalleja ovat mm. Claude, Open AI:n Chat GPT ja Co-pilot, Krock, Gemini, Mistral, Deep seek ja lukuisia muita. Suuria kielimalleja on arvosteltu, että ne hallusinoivat eli niiden tuottamat ratkaisut eivät ole luotettavia tai sisältö on sinnepäin eikä riittävän käyttökelpoista. Tekoälyn tuottaman prosessin läpinäkymättömyyttä on pidetty myös ongelmana. Arvioitaessa tekoälyä on huomioitava, että uusissa innovaatioissa on aina alkuvaiheessa puutteita ja ne vähenevät ajansaatossa. Toiseksi harva järjestelmä on erehtymätön. Eli odotukset ja arviot kannattaa suhteuttaa saatavaan hyötyyn ja pyrkiä minimoimaan haitat.

A koulutuksessa (opetuksessa) ja arviointi

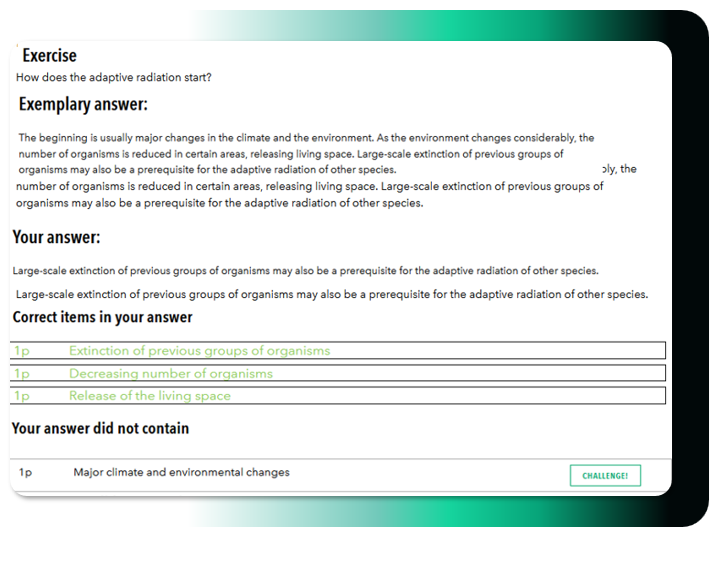

Opetuksen ja koulutuksen alalla on monia erilaisia kohtia, joissa voidaan hyödyntää tekoälyä. Eräs vaikeimpia osa-alueita on kuitenkin tekstien ja kirjoitelmien tarkastus ja arviointi. Arvioinnilla voi olla opiskeljan opintomenestykseen ja jatkosuunnitelmiin keskeinen vaikutus. Ehkä kriittisin tilanne on opiskelijoiden luokittelussa vastausten mukaan ja valintatilanteissa jatko-opiskeluun (pääsykokeet) tai esimerkiksi työnhakuun liittyvissä tilanteissa.

EU:n AI-asetus ja ihmisen rooli

The EU AI Act regulates the role of AI in education, emphasizing the importance of human-led instruction. To mitigate uncertainty, the Act underscores that humans must remain central to assessment and guidance. AI-driven solutions must be non-discriminatory, reliable, and fair—mirroring the requirements placed on human evaluators.

Key safety features include:

- The Right to Rectification: There must always be a way to appeal and correct an erroneous AI interpretation.

- Two-Step Process: AI generates an assessment proposal, which a human then reviews and verifies.

- Objectivity: AI promotes fairness by processing anonymized student responses.

Risk Classification and Compliance

Under the EU AI Act, AI-based assessment is classified as High-Risk (Category 4), especially when used for student profiling or predicting performance.

Eximiatutor’s Teacher Tool is designed to be fully compliant with the EU AI Act. It does not perform automated high-stakes decision-making or profiling. The system has undergone rigorous GDPR, DPIA, and FRIA (Fundamental Rights Impact Assessment) evaluations to ensure data privacy and ethical standards.

The Eximiatutor Hybrid-AI Approach

Our aicheq technology utilizes a “Hybrid-AI” model (NLP, Classification, and LLM). Its core strength lies in classification and NLP, where:

- Teachers Maintain Control: Teachers create the tasks and set the factual criteria based on the curriculum.

- Transparency: This ensures clear understanding of the grounds for assessment.

- Human-in-the-Loop: The teacher always confirms or edits the AI’s assessment proposal.

AI is a powerful tool, but its use must be guided and managed. Whether generating study materials or assessing work, the human creator remains responsible for the accuracy and utility of the content.